GMI Cloud Inference Engine

GMI Cloud Inference Engine是全球 AI 模型统一接入与在线使用的“高性能推理引擎平台”。

AI Infra

4 喜欢4

3 评论3

2个月前发布

演示视频与截图

简短介绍

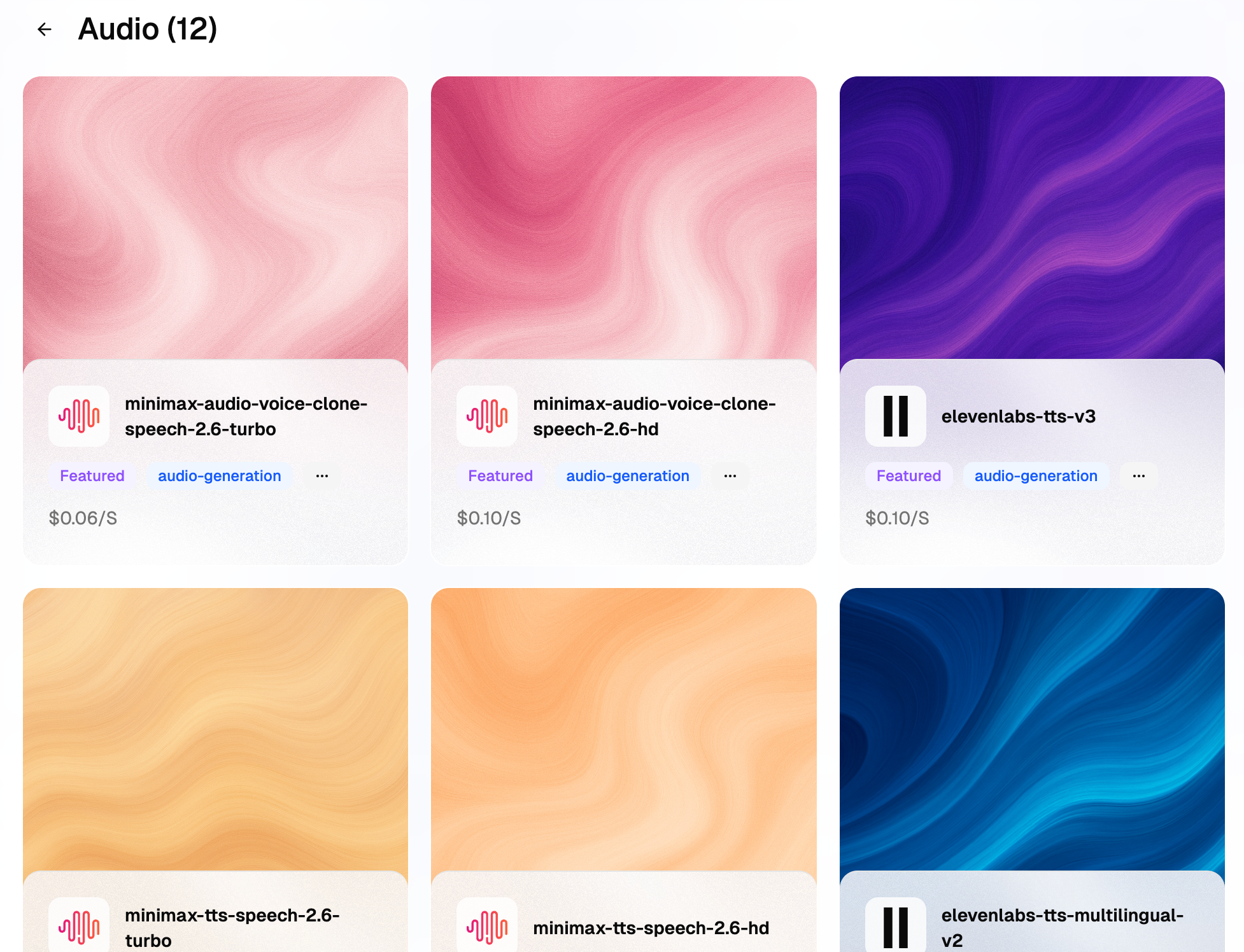

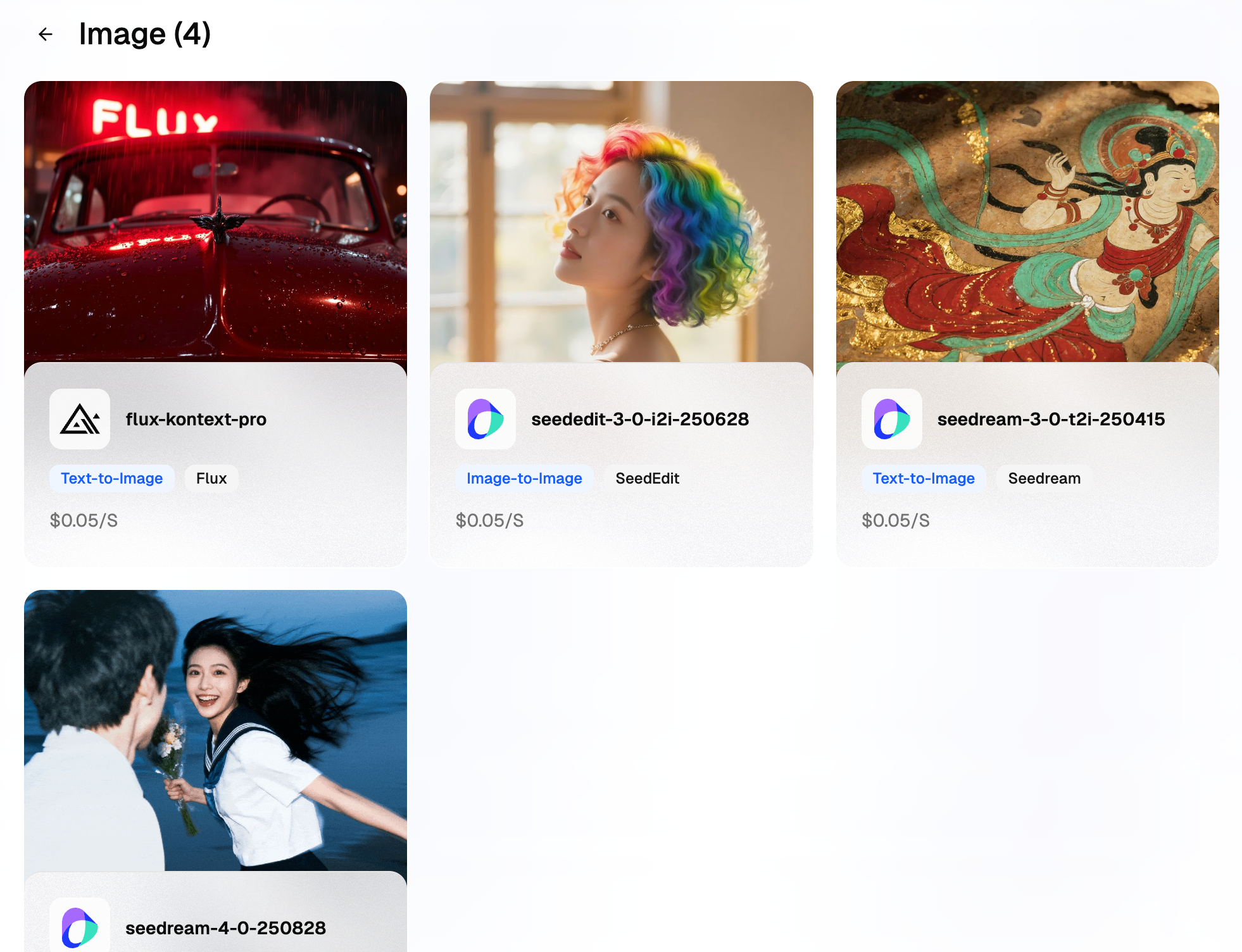

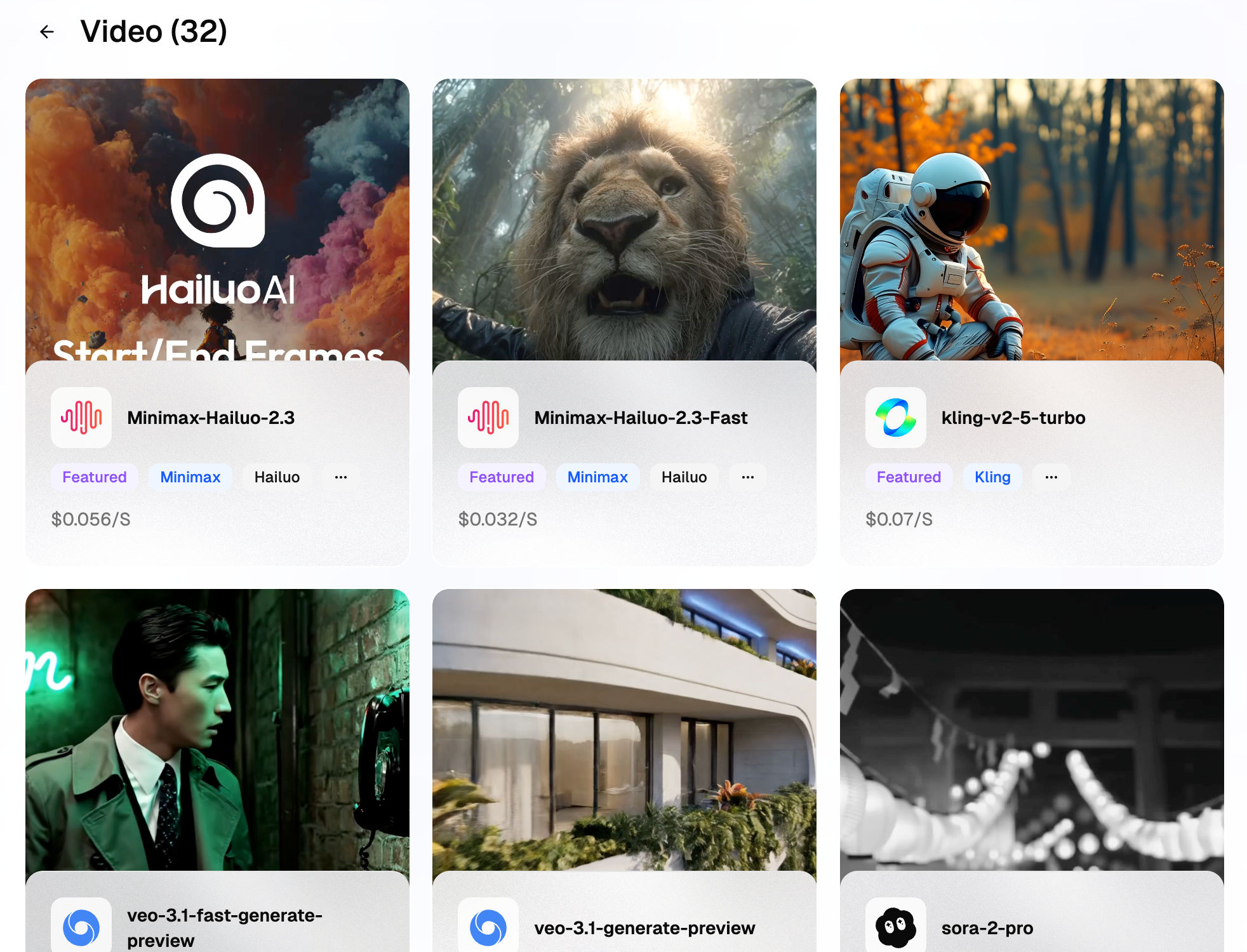

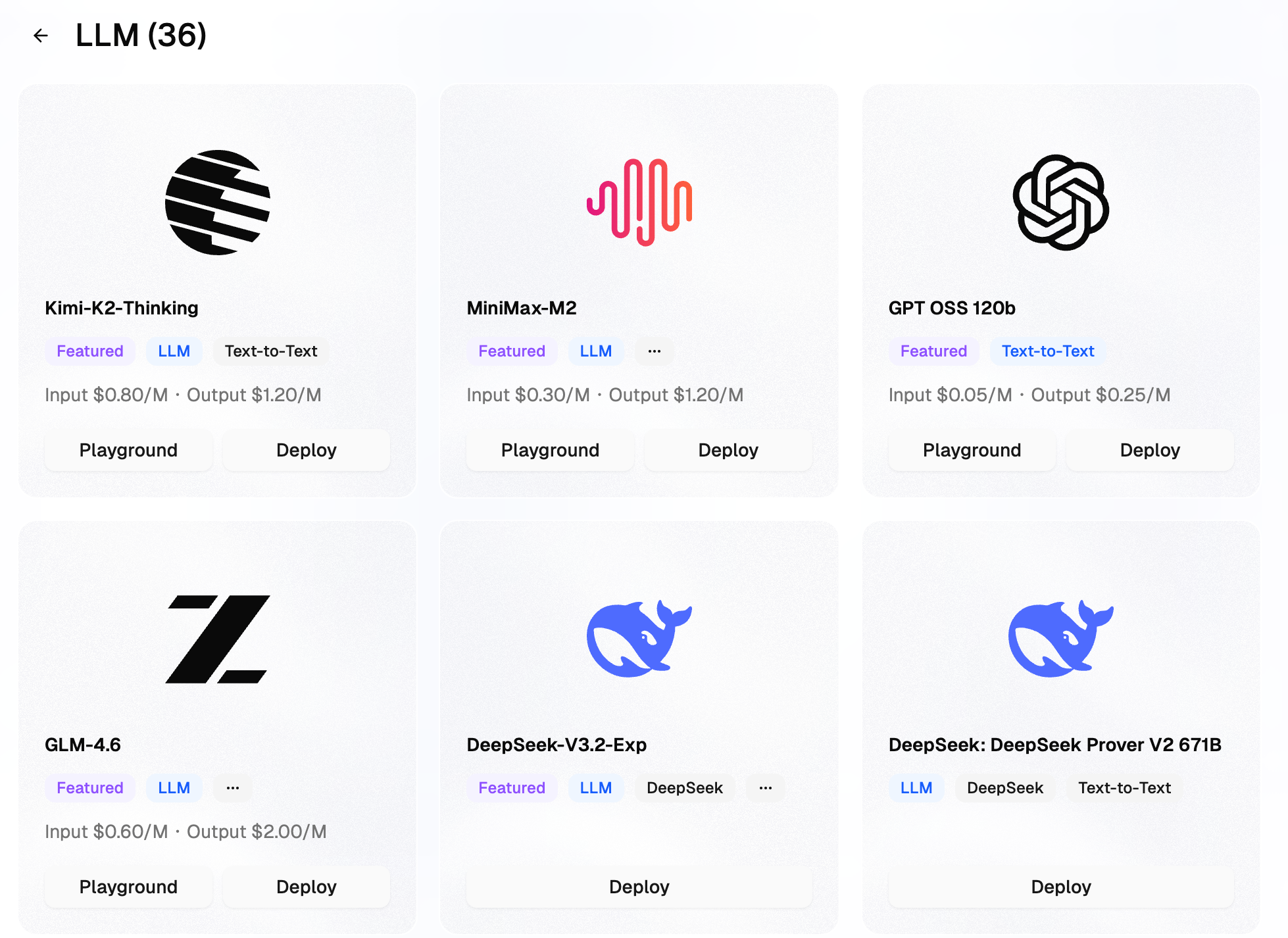

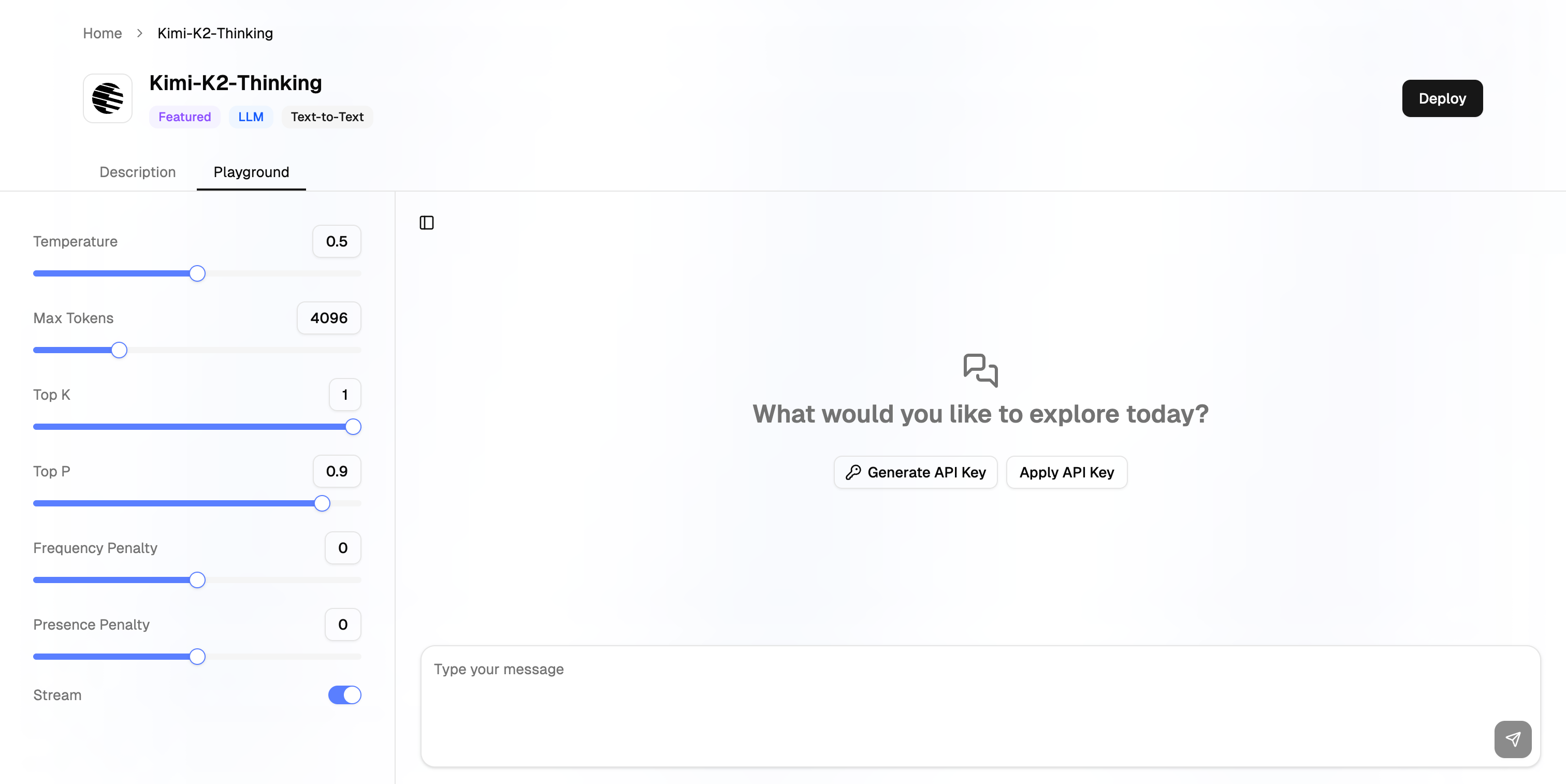

GMI Cloud Inference Engine是全球 AI 模型统一接入与在线使用的“高性能推理引擎平台”,底层搭载H100/H200芯片,集成全球近百个最前沿的LLM、Video、Image、Audio模型,为AI开发者与企业提供速度更快、质量更高的模型服务。

开发者/推荐人

VC

开发者北京市

李森

开发者

用户评论 (3)

发表评论

VC

在做 AI 应用落地时,最头疼的往往是碎片化的 API 管理和难以控制的推理成本——想用 Hailuo 做视频、Flux 画图、DeepSeek 做推理……叠加起来可能要维护十几套 SDK,还要担心生产环境的稳定性。如果你也有这些困扰, GMI Cloud Inference Engine 绝对值得来了解!

💡 核心产品特性:

🌐 多云资源聚合 (Inference Engine 2.0):

Inference Engine 底层升级,不仅拥有自建高性能集群,更整合了 AWS、GCP 等多云资源。这意味着开发者可以获得更具弹性的算力池,有效缓解高峰期排队问题。

🔌 统一 API 开发体验:

提供标准化的 API 接口,一站式接入 Video (Sora 2, Wan 2.5, Hailuo), LLM (DeepSeek V3, Qwen 3), Image (Flux) 等主流模型。无需维护多套 SDK,大幅降低 Agent 开发复杂度。

🛡️ 灵活部署方式:

支持 云端 API 调用 与 Docker 私有化部署 两种模式。企业客户可根据数据合规需求,灵活选择部署方案。

💰 成本透明可控:

采用 按 Token / 生成次数 的灵活计费模式,用多少算多少,避免传统包年包月模式的资源浪费。

🎁 社区福利: 很高兴入驻模力工厂!我们准备了 100 个社区专属 Token 兑换码。 欢迎大家体验最新的多模态模型推理服务!👇

福利兑换/入门教程

实操案例:

Dify 上线 GMl Cloud 插件!构建深度研究工作流只需 5 步!

Cursor x GMI Cloud 零基础教程:用 Inference Engine 生成你的第一个小程序

给我60分钟!手把手教你用一个API搞定"热梗表情包生成器"

无缝集成,高效输出:我的 GMI Cloud AI 初体验

从Token调用到专用部署,我的AI开发实录

一个账号调用N个AI模型!从LLM到视频生成的丝滑解决方案

付秋伟

低调